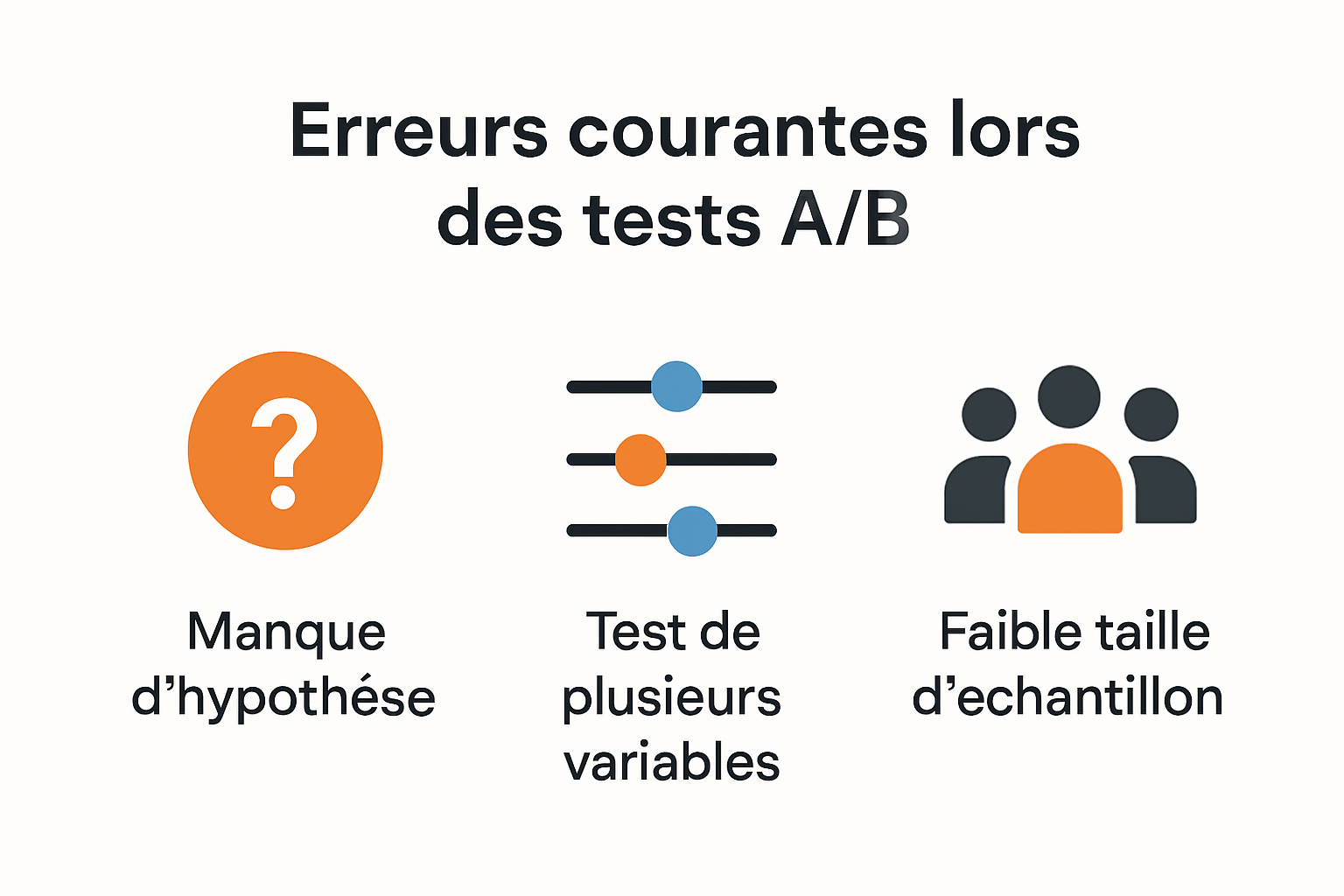

Évitez ces erreurs courantes A/B testing en 2025

Le A/B testing attire de plus en plus de professionnels qui cherchent à améliorer leurs résultats, mais une statistique fait réfléchir. Un test A/B sur deux conduit à une décision erronée lorsqu’il n’est pas correctement structuré. Surprenant, non. Ce n'est pourtant pas la complexité technologique qui piège le plus, mais des erreurs toutes simples comme oublier la taille d’échantillon et la segmentation des utilisateurs qui font basculer tout le test.

Table des matières

- Comprendre Les Mauvaises Pratiques En A/B Testing

- Erreurs De Conception Et D'Échantillonnage

- Interprétation Erronée Des Résultats A/B

- Bonnes Pratiques Pour Des Tests Fiables En 2025

Quick Summary

| Takeaway | Explanation |

|---|---|

| Définir une hypothèse claire | Une hypothèse précise est essentielle pour structurer le test et obtenir des résultats exploitables. |

| Tester une seule variable à la fois | Cela permet d'identifier clairement l'impact de chaque changement, évitant ainsi la confusion. |

| Éviter les biais de sélection | Un échantillon représentatif reflète fidèlement votre population cible, garantissant des résultats fiables. |

| Respecter un seuil de signification statistique | Il est crucial de définir un seuil (généralement 95%) pour éviter des conclusions hâtives et erronées. |

| Interpréter les résultats avec nuance | Une analyse approfondie des résultats, tenant compte des segments d'utilisateurs, aide à comprendre les raisons des performances. |

Comprendre les mauvaises pratiques en A/B testing

Le test A/B représente un outil puissant pour optimiser les performances numériques, mais sa mise en œuvre nécessite une approche stratégique et méthodique. Les erreurs courantes peuvent non seulement compromettre la validité des résultats, mais aussi conduire à des décisions marketing potentiellement contre-productives.

Les pièges méthodologiques du test A/B

Lorsque vous entreprenez un test A/B, la première erreur critique consiste à ne pas définir une hypothèse claire et précise. Selon une étude de Marketing Accelerator, de nombreux professionnels lancent des expériences sans objectif stratégique bien défini.

Par exemple, au lieu de simplement tester deux versions d'une page web, vous devez vous demander : "Quel changement spécifique pourrait améliorer mon taux de conversion ?" Cette approche ciblée permet de structurer votre test et d'obtenir des résultats exploitables.

Une autre erreur fréquente consiste à tester trop de variables simultanément. Comme le souligne Startup Nation, multiplier les modifications complique l'identification précise de l'impact de chaque élément. Un bon test A/B se concentre sur une modification unique et mesurable.

Comprendre la signification statistique

Ne pas tenir compte de la signification statistique représente un risque majeur. Tous les résultats de test ne sont pas également pertinents. Un échantillon trop petit ou une période de test trop courte peuvent conduire à des conclusions hâtives et potentiellement erronées.

Les professionnels chevronnés recommandent de :

- Déterminer la taille d'échantillon requise avant de commencer le test

- Définir un seuil de signification statistique (généralement 95%)

- Collecter suffisamment de données avant de tirer des conclusions

Les aspects techniques à ne pas négliger

Les aspects techniques du test A/B sont souvent sous-estimés. Il est crucial de garantir que votre implémentation technique ne faussera pas les résultats. Cela implique de :

- Vérifier la compatibilité entre les différentes versions

- Assurer un chargement cohérent des variantes

- Éliminer les biais potentiels liés aux technologies

En comprenant et en évitant ces erreurs courantes, vous positionnez votre stratégie de test A/B pour générer des insights véritablement exploitables et transformer vos performances numériques.

Erreurs de conception et d'échantillonnage

Les tests A/B reposent sur une méthodologie précise où la conception et l'échantillonnage jouent un rôle crucial. Une erreur à ces étapes peut compromettre l'intégralité de votre expérimentation et conduire à des décisions marketing potentiellement erronées.

La sélection et la représentativité de l'échantillon

La qualité de votre échantillon détermine directement la fiabilité de vos résultats. Selon une étude publiée dans le National Center for Biotechnology Information, un déséquilibre dans la répartition des participants entre les variantes peut introduire des biais significatifs.

Un échantillon représentatif doit refléter précisément les caractéristiques de votre population cible. Cela signifie prendre en compte des facteurs tels que :

- L'âge

- Le sexe

- La localisation géographique

- Le comportement en ligne

Éviter les biais de sélection est essentiel. Comme le souligne Wikipedia dans son article sur l'échantillonnage, une sélection biaisée peut conduire à des erreurs systématiques qui rendent vos résultats non représentatifs.

Stratégies de dimensionnement et de précision

Une recherche de Bookdown montre que l'augmentation de la taille de l'échantillon réduit significativement l'erreur d'échantillonnage. Plus votre échantillon est grand, plus vos estimations seront précises.

Pour garantir la robustesse de votre test, considérez :

- Calculer la taille minimale d'échantillon nécessaire avant le test

- Maintenir un équilibre strict entre les groupes de test

- Utiliser des outils statistiques pour valider la significativité

Les pièges techniques à éviter

Plusieurs erreurs techniques peuvent compromettre la validité de votre test A/B :

- Durée inadéquate du test : Un test trop court ne capture pas toutes les variations de comportement

- Segmentation insuffisante : Ne pas tenir compte des différents segments d'utilisateurs

- Outils de mesure inappropriés : Utiliser des métriques qui ne reflètent pas réellement votre objectif

Chaque décision méthodologique doit être prise avec précaution. Un test A/B mal conçu est non seulement inutile, mais peut également induire en erreur et conduire à des stratégies marketing contre-productives.

En maîtrisant ces aspects techniques et méthodologiques, vous transformez votre test A/B d'un simple exercice en un véritable outil de prise de décision stratégique.

Pour clarifier les principales erreurs d'échantillonnage et de technique décrites ci-dessus, voici un tableau récapitulatif des pièges courants et des solutions recommandées :

| Erreur Courante | Conséquence | Solution Recommandée |

|---|---|---|

| Déséquilibre des groupes | Biais dans les résultats | Maintenir l'équilibre lors de la répartition |

| Taille d'échantillon insuffisante | Résultats statistiquement non fiables | Calculer la taille minimale nécessaire |

| Durée de test trop courte | Variations comportementales non capturées | Définir une durée minimale de test |

| Mauvaise segmentation | Insights importants non révélés | Segmenter par appareil, géo, démographie |

| Outils de mesure inadaptés | Mesure des mauvaises métriques | Choisir des indicateurs alignés avec l'objectif |

Interprétation erronée des résultats A/B

L'interprétation des résultats de tests A/B représente un défi crucial où de nombreux professionnels commettent des erreurs stratégiques. Une analyse superficielle ou précipitée peut conduire à des décisions marketing contre-productives.

Les pièges de la signification statistique

Selon CXL, ignorer la signification statistique est l'une des erreurs les plus courantes. Un résultat qui semble prometteur ne garantit pas automatiquement une amélioration réelle des performances.

Pour éviter ces écueils, il est essentiel de :

- Définir un seuil de confiance statistique (généralement 95%)

- Calculer la taille d'échantillon nécessaire avant de commencer

- Ne pas interrompre prématurément un test en cours

Les dangers des conclusions hâtives

Comme le souligne CIO, arrêter un test trop tôt constitue un risque majeur. Les résultats initiaux peuvent être trompeurs et ne pas refléter la tendance réelle sur le long terme.

Quatre étapes pour une interprétation robuste :

- Définir une durée de test minimale

- Attendre d'obtenir un nombre suffisant de conversions

- Vérifier la cohérence des résultats

- Examiner les variations à différents moments

Segmentation et contexte

D'après les experts en analyse, négliger la segmentation des utilisateurs peut masquer des insights précieux. Chaque segment de votre audience peut réagir différemment aux variations testées.

Stratégies de segmentation efficaces :

- Analyser les résultats par type d'appareil

- Considérer les différences géographiques

- Prendre en compte les canaux d'acquisition

- Examiner les comportements démographiques

Une interprétation nuancée et méthodique des résultats A/B transforme votre approche marketing. Au lieu de vous fier à des impressions superficielles, vous construisez une compréhension approfondie du comportement de vos utilisateurs.

Rappellez-vous : un test A/B réussi ne se limite pas à identifier un gagnant, mais à comprendre pourquoi une variante performe mieux que l'autre. Cette approche analytique vous permettra de prendre des décisions stratégiques fondées sur des données solides.

Pour mieux visualiser l'enchaînement correct d'une analyse statistique en tests A/B, voici un tableau synthétique des étapes clés à respecter :

| Étape d'Analyse | Action Essentielle | Objectif |

|---|---|---|

| Définir un seuil de confiance | Choisir 95% ou plus | Éviter les faux positifs |

| Calculer la taille d'échantillon | Utiliser des outils statistiques | Obtenir des résultats fiables |

| Fixer la durée du test | Ne pas interpréter trop vite les résultats | Permettre l'émergence de tendances réelles |

| Segmenter les résultats | Analyser par appareil, géo, canal, démographie | Obtenir des insights spécifiques par audience |

| Vérifier la cohérence des données | Étudier la stabilité au fil du temps | Éviter les biais dus à des périodes particulières |

Bonnes pratiques pour des tests fiables en 2025

À l'horizon 2025, les tests A/B continuent d'évoluer, exigeant des professionnels du marketing une approche plus sophistiquée et méthodique. La fiabilité des tests repose désormais sur des stratégies précises et une compréhension approfondie des mécanismes d'expérimentation.

Définir des objectifs stratégiques précis

Selon l'organisme de marketing néo-zélandais, définir des objectifs clairs et mesurables constitue le fondement de tout test A/B performant. Un objectif vague conduit invariablement à des résultats inexploitables.

Les objectifs efficaces doivent être :

- Spécifiques : Augmenter le taux de conversion de X%

- Mesurables : Avoir des indicateurs précis

- Réalistes : En adéquation avec vos ressources

- Temporellement définis : Avec une période de test précise

Méthodologie de test rigoureuse

D'après Invesp, tester une seule variable à la fois représente une stratégie cruciale. Cette approche permet d'isoler précisément l'impact de chaque modification.

Étapes de mise en œuvre :

- Identifier la variable à tester

- Créer deux versions distinctes

- Maintenir toutes les autres conditions constantes

- Mesurer l'impact spécifique de la modification

Calcul et validité statistique

Une recherche récente publiée sur Arxiv souligne l'importance de calculer précisément la taille d'échantillon nécessaire. Un échantillon mal dimensionné compromet la fiabilité statistique de l'ensemble du test.

Éléments clés pour garantir la validité :

- Déterminer le niveau de confiance requis (généralement 95%)

- Calculer la taille minimale d'échantillon

- Utiliser des outils statistiques de calcul

- Prévoir une durée de test suffisante

En 2025, les tests A/B ne sont plus seulement un outil marketing, mais une discipline scientifique exigeant rigueur, méthode et compréhension approfondie des mécanismes statistiques. Chaque test devient une opportunité d'apprentissage stratégique, transformant les données brutes en véritables insights opérationnels.

L'expertise réside désormais dans la capacité à concevoir des expérimentations précises, à interpréter des résultats complexes et à traduire ces connaissances en actions marketing concrètes et performantes.

Questions Fréquemment Posées

Qu'est-ce que le test A/B et pourquoi est-il important ?

Le test A/B est une méthode d'expérimentation qui consiste à comparer deux versions d'une page ou d'un élément pour déterminer laquelle performe le mieux. Il est important car il permet d'optimiser les performances numériques en basant les décisions sur des données concrètes.

Quelles sont les erreurs courantes à éviter lors d'un test A/B ?

Les erreurs courantes incluent ne pas définir d'hypothèse claire, tester plusieurs variables simultanément, ignorer la taille d'échantillon adéquate et ne pas prendre en compte la signification statistique des résultats.

Comment choisir la taille d'échantillon pour un test A/B ?

Pour choisir la taille d'échantillon, il est essentiel de définir le niveau de confiance souhaité, souvent fixé à 95%, et d'utiliser des outils statistiques pour calculer la taille minimale nécessaire en fonction de l'objectif du test.

Pourquoi est-il important de segmenter les utilisateurs dans un test A/B ?

La segmentation des utilisateurs est cruciale car elle permet d’obtenir des insights plus précis. Chaque segment peut réagir différemment aux variations testées, ce qui aide à comprendre les besoins spécifiques de votre audience.

Transformez vos tests A/B en succès mesurables dès aujourd’hui

Vous avez découvert à quel point la moindre erreur méthodologique peut fausser vos résultats et freiner la croissance de votre entreprise. Complexité technique, mauvaise segmentation ou taille d’échantillon mal calculée, tout cela peut anéantir des heures de travail et faire douter de la validité de vos décisions. Avec Stellar, dites adieu à l’incertitude et devenez le maître de vos expérimentations. Notre plateforme SaaS allège vos tests grâce à un script ultraléger et un éditeur visuel sans code. Configurez des expériences en toute simplicité, suivez chaque conversion en temps réel et éliminez les erreurs critiques décrites dans cet article.

Pourquoi attendre pour fiabiliser votre stratégie digitale ? Essayez Stellar gratuitement dès maintenant et découvrez comment notre A/B Testing Tool peut faire passer vos résultats au niveau supérieur. Maximisez l’efficacité de chaque test, accédez à des statistiques immédiatement exploitables et transformez vos données en décisions concrètes. Commencez avec notre plan gratuit pour PME : l’optimisation n’a jamais été aussi accessible.

Recommended

Published: 7/17/2025