Limites du A/B Testing : comprendre et dépasser les freins en 2025

Le A/B testing fascine encore de nombreuses équipes qui cherchent à améliorer leurs taux de conversion, surtout quand on apprend que 95% de confiance statistique signifie malgré tout 5% de marge d’erreur dans leurs résultats. Sauf que cette certitude apparente cache un piège. La vraie claque, c’est que de simples tests A/B peuvent donner une fausse impression de progrès alors qu’ils manquent toute la richesse des motivations et interactions réelles des utilisateurs.

Table des matières

- Les Principales Limites Du A/B Testing

- Comment Ces Limites Freinent L'Optimisation Des Conversions

- Alternatives Et Solutions Pour Dépasser Le A/B Testing

Quick Summary

| Takeaway | Explanation |

|---|---|

| Des résultats statistiquement imprécis | Le A/B testing peut produire des résultats trompeurs en raison d'échantillons insuffisants ou de périodes de test inappropriées, entraînant des décisions stratégiques risquées basées sur des probabilités plutôt que des certitudes. |

| Complexité des interactions | Les tests A/B traditionnels ont du mal à capturer les interactions complexes entre divers éléments, ce qui peut fausser l'interprétation des données et réduire l'efficacité des optimisations. |

| Importance des méthodes qualitatives | Compléter les tests A/B par des approches qualitatives comme les entretiens utilisateurs aide à saisir les motivations et émotions des utilisateurs, offrant une compréhension plus riche de leur comportement. |

| Adopter des alternatives sophistiquées | Les tests multivariés et les analyses basées sur l'intelligence artificielle représentent des alternatives valables pour surmonter les limitations du A/B testing et offrir une personnalisation et une optimisation plus précises. |

Les principales limites du A/B testing

Le A/B testing, bien qu'étant un outil puissant pour l'optimisation des conversions, présente plusieurs défis significatifs que les marketeurs et les équipes produit doivent comprendre et anticiper. Ces limites peuvent compromettre la validité et l'efficacité des tests, nécessitant une approche critique et nuancée.

Des résultats statistiquement imprécis et potentiellement trompeurs

Une limite majeure du A/B testing réside dans la potentielle imprécision statistique des résultats. Une étude de l'Université de Stanford souligne que les tests mal conçus peuvent conduire à des conclusions erronées. Les erreurs courantes incluent des tailles d'échantillon insuffisantes, des périodes de test trop courtes ou une interprétation incorrecte des données statistiques.

Par exemple, un test considéré comme statistiquement significatif avec un taux de confiance de 95% signifie qu'il existe encore 5% de chances que le résultat soit dû au hasard. Cette marge d'erreur peut être critique lors de prises de décisions stratégiques basées uniquement sur ces résultats.

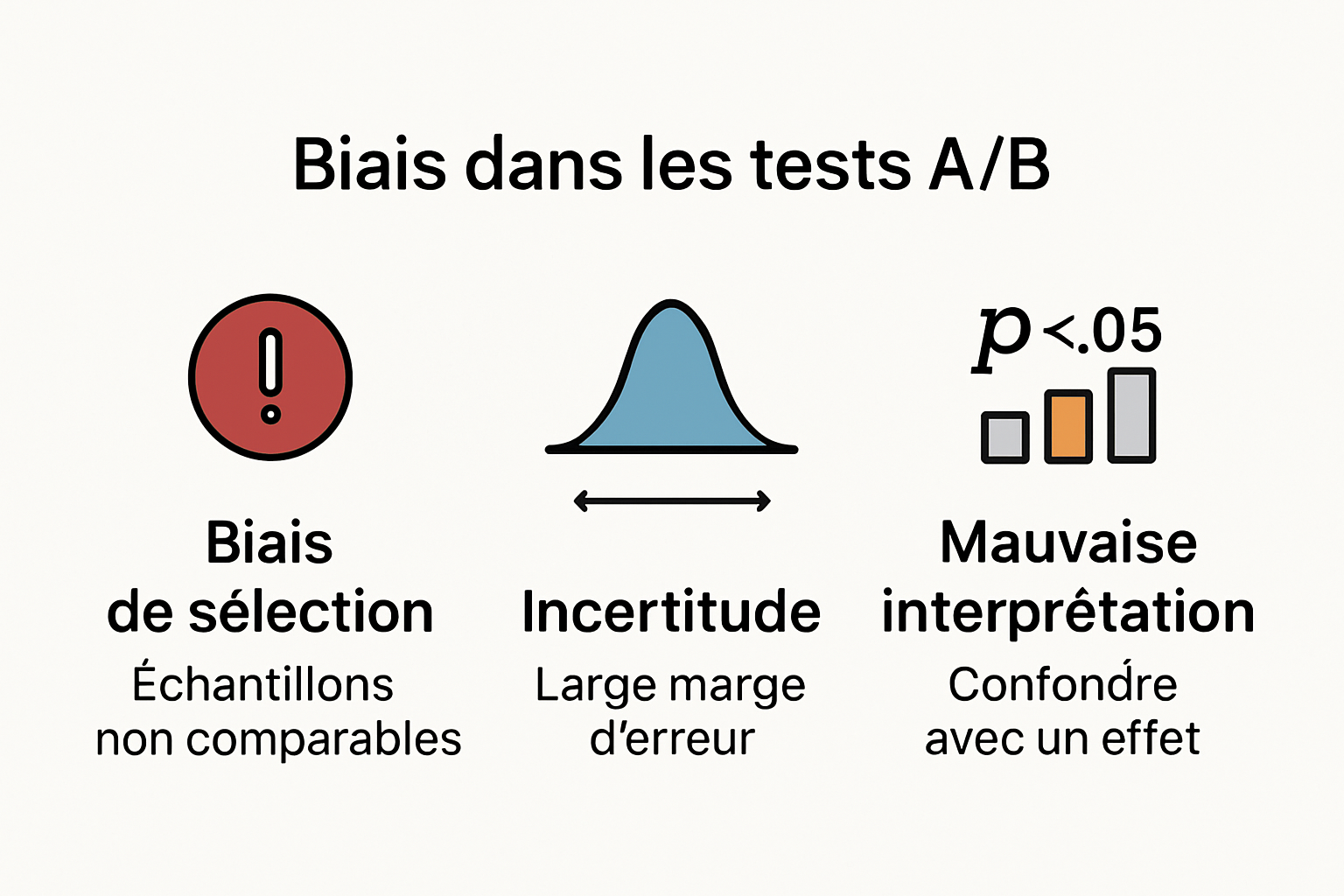

Biais et limitations contextuelles du A/B testing

Le A/B testing souffre également de limitations contextuelles importantes. Selon une recherche de Harvard Business Review, les tests ne capturent pas toujours la complexité du comportement utilisateur dans différents contextes. Les variations peuvent donner des résultats différents selon :

- Le moment de la journée

- Le dispositif utilisé

- Le profil démographique des utilisateurs

Ces variations rendent difficile la généralisation des résultats et nécessitent une approche plus nuancée de l'interprétation des données.

La complexité des interactions et des effets de interaction

Un autre défi majeur concerne la complexité des interactions entre différents éléments testés. Un changement apparemment mineur peut avoir des répercussions inattendues sur l'expérience utilisateur globale. Les tests A/B traditionnels peinent à capturer ces interactions multidimensionnelles.

Les marketeurs doivent donc adopter une approche holistique, combinant A/B testing avec d'autres méthodes d'analyse comme les tests multivariants, les études qualitatives et l'analyse comportementale approfondie.

En conclusion, comprendre les limites du A/B testing est essentiel pour éviter les pièges de l'interprétation simpliste des données. Une approche critique, méthodique et consciente de ces contraintes permettra des décisions plus éclairées et plus performantes.

Comment ces limites freinent l'optimisation des conversions

Les limites intrinsèques du A/B testing peuvent significativement entraver les efforts d'optimisation des conversions, créant des obstacles subtils mais puissants qui empêchent les équipes marketing et produit de maximiser leur potentiel réel.

La fausse impression de certitude statistique

Une recherche de McKinsey révèle un problème crucial : les marketeurs interprètent souvent les résultats statistiques comme des vérités absolues, alors qu'ils ne sont que des probabilités. Cette sur-interprétation conduit à des décisions stratégiques potentiellement erronées.

Les tests A/B génèrent des données qui semblent précises, mais comportent intrinsèquement une marge d'erreur. Par exemple, un taux de conversion amélioré de 2% peut facilement être statistiquement insignifiant, malgré son apparence attrayante. Cette illusion de progrès peut détourner les équipes des véritables leviers d'amélioration.

L'impact négatif sur l'expérience utilisateur globale

L'étude de Nielsen Norman Group souligne un autre problème majeur : les tests A/B fragmentent l'expérience utilisateur. En testant des éléments isolés, on risque de compromettre la cohérence et la fluidité de l'interaction.

Les conséquences peuvent être significatives :

- Discontinuité de l'expérience utilisateur

- Perturbation des parcours de navigation

- Création de versions incohérentes de l'interface

Chaque test représente potentiellement une interruption dans l'expérience utilisateur, ce qui peut paradoxalement réduire les taux de conversion au lieu de les améliorer.

La limitation de la compréhension du comportement utilisateur

Les tests A/B offrent une vision réductrice et quantitative du comportement utilisateur. Ils capturent des données binaires mais manquent la profondeur des motivations et des émotions qui sous-tendent les décisions.

Un changement de bouton ou de couleur peut augmenter mécaniquement les conversions, mais ne répond pas nécessairement aux véritables besoins et attentes des utilisateurs. Cette approche purement mécanique néglige les aspects qualitatifs essentiels de l'expérience utilisateur.

Pour surmonter ces limites, les équipes doivent adopter une stratégie d'optimisation plus holistique. Cela implique de combiner A/B testing avec des méthodes qualitatives comme les entretiens utilisateurs, les tests de parcours et l'analyse comportementale approfondie.

En fin de compte, le A/B testing reste un outil précieux, mais doit être utilisé avec discernement, comme un élément d'une stratégie d'optimisation plus large et plus nuancée.

Pour mieux visualiser comment les limites identifiées affectent différents aspects de l'optimisation des conversions, voici un tableau récapitulatif :

| Limite du A/B Testing | Conséquence principale | Exemple concret |

|---|---|---|

| Imprécision statistique | Décisions basées sur des résultats non fiables | Prendre une décision sur un « uplift » de 2% qui n’est pas avéré |

| Biais et contexte ignorés | Résultats non généralisables | Une variante performe à midi mais pas le soir |

| Fragmentation de l’expérience utilisateur | Dégradation de la cohérence et du parcours | Utilisateurs perdus entre plusieurs versions d’une même page |

| Compréhension limitée du comportement | Optimisation superficielle et non durable | Bouton plus visible augmente les clics sans répondre au besoin |

Alternatives et solutions pour dépasser le A/B testing

Face aux limitations évidentes du A/B testing, les marketeurs et les équipes produit doivent explorer des approches alternatives plus sophistiquées pour comprendre et optimiser l'expérience utilisateur.

Tests multivariés et approches analytiques avancées

Selon une étude de Forrester Research, les tests multivariés offrent une perspective plus nuancée que le traditionnel A/B testing. Contrairement aux tests A/B qui comparent deux versions distinctes, les tests multivariés permettent d'analyser simultanément plusieurs variables et leurs interactions complexes.

Cette méthode permet de comprendre comment différents éléments interagissent et influencent le comportement utilisateur. Par exemple, on peut tester simultanément la couleur d'un bouton, son emplacement et son libellé, plutôt que de les examiner isolément.

Le tableau suivant compare les différentes approches d’optimisation évoquées dans cet article :

| Approche | Atout principal | Limite principale | Type de données |

|---|---|---|---|

| A/B Testing | Simplicité, rapidité de mise en œuvre | Ne capture pas la complexité des interactions | Quantitatives |

| Test multivarié | Analyse des interactions multiples | Complexité technique, besoin d’un trafic plus élevé | Quantitatives |

| Recherche utilisateur qualitative | Compréhension profonde des comportements | Prend du temps, biais possible dans la collecte | Qualitatives |

| Analyse par IA/machine learning | Prédictions personnalisées, segmentation fine | Nécessite expertise technique et beaucoup de données | Quant. & Qualitatives |

Approches qualitatives et recherche utilisateur approfondie

La recherche de l'Interaction Design Foundation souligne l'importance des méthodes qualitatives pour compléter les données quantitatives. Les techniques comme les entretiens utilisateurs, les tests de parcours et les études de cas offrent une compréhension plus profonde des motivations et des comportements.

Les méthodes qualitatives permettent de:

- Comprendre les émotions et les motivations

- Identifier les obstacles non apparents

- Générer des insights qualitatifs

- Contextualiser les données quantitatives

Approches analytiques avancées et intelligence artificielle

L'émergence de l'intelligence artificielle et du machine learning transforme radicalement l'approche de l'optimisation. Une étude de McKinsey montre que ces technologies permettent des analyses prédictives beaucoup plus sophistiquées que le A/B testing traditionnel.

Les outils basés sur l'IA peuvent :

- Analyser des modèles comportementaux complexes

- Prédire les comportements futurs

- Personnaliser les expériences en temps réel

- Identifier des corrélations subtiles

Par exemple, les algorithmes d'apprentissage automatique peuvent identifier des segments d'utilisateurs avec des besoins et des comportements spécifiques, permettant une personnalisation bien plus fine que les tests A/B classiques.

Ces alternatives ne remplacent pas complètement le A/B testing, mais l'enrichissent. L'objectif est de développer une approche holistique qui combine données quantitatives, insights qualitatifs et technologies avancées pour vraiment comprendre et optimiser l'expérience utilisateur.

Questions Fréquemment Posées

Qu'est-ce que le A/B testing et pourquoi est-il utilisé ?

Le A/B testing est une méthode de comparaison de deux versions d'une page ou d'un élément pour déterminer laquelle est la plus efficace en termes de conversions. Il est largement utilisé pour optimiser les performances de sites web et d'applications.

Quelles sont les principales limites du A/B testing ?

Les principales limites du A/B testing incluent des résultats statistiquement imprécis, des biais contextuels, et une incapacité à capturer la complexité des interactions entre éléments. Ces facteurs peuvent mener à des décisions erronées basées sur des données peu fiables.

Comment le A/B testing peut-il nuire à l'expérience utilisateur ?

Le A/B testing peut fragmenter l'expérience utilisateur en testant des éléments isolés, ce qui peut créer une incohérence dans l'interface et perturber la navigation. Cela peut, paradoxalement, entraîner une diminution des conversions.

Quelles sont les alternatives au A/B testing pour améliorer l'optimisation des conversions ?

Des alternatives comprennent les tests multivariés, les recherches qualitatives pour saisir les motivations des utilisateurs, et l'utilisation d'analyses basées sur l'intelligence artificielle pour des prédictions personnalisées et une segmentation fine des utilisateurs.

Passez des limites du A/B Testing traditionnel à la performance avec Stellar

Vous avez reconnu dans cet article que le A/B testing classique atteint vite ses limites quand il s'agit de précision, de compréhension réelle du comportement utilisateur ou de rapidité d'exécution. Si vous cherchez à dépasser la frustration des résultats trop incertains ou des outils complexes, il existe aujourd'hui une voie plus simple et plus efficace.

Essayez une nouvelle génération d'expérimentation en ligne avec Stellar. Profitez d'un éditeur visuel sans code, d'un script ultra léger pour ne pas ralentir votre site, et d'une analyse en temps réel pensée pour les équipes marketing. Découvrez comment notre solution SaaS rend l'optimisation accessible à tous, sans surcharge technique et avec des résultats fiables. Commencez dès maintenant à tester vos idées avec la plateforme la plus rapide du marché. Ne laissez plus vos conversions au hasard, offrez-vous une expérience plus performante et transparente.

Recommended

Published: 7/21/2025