Split Testing vs A/B Testing: Unterschiede und beste Einsätze

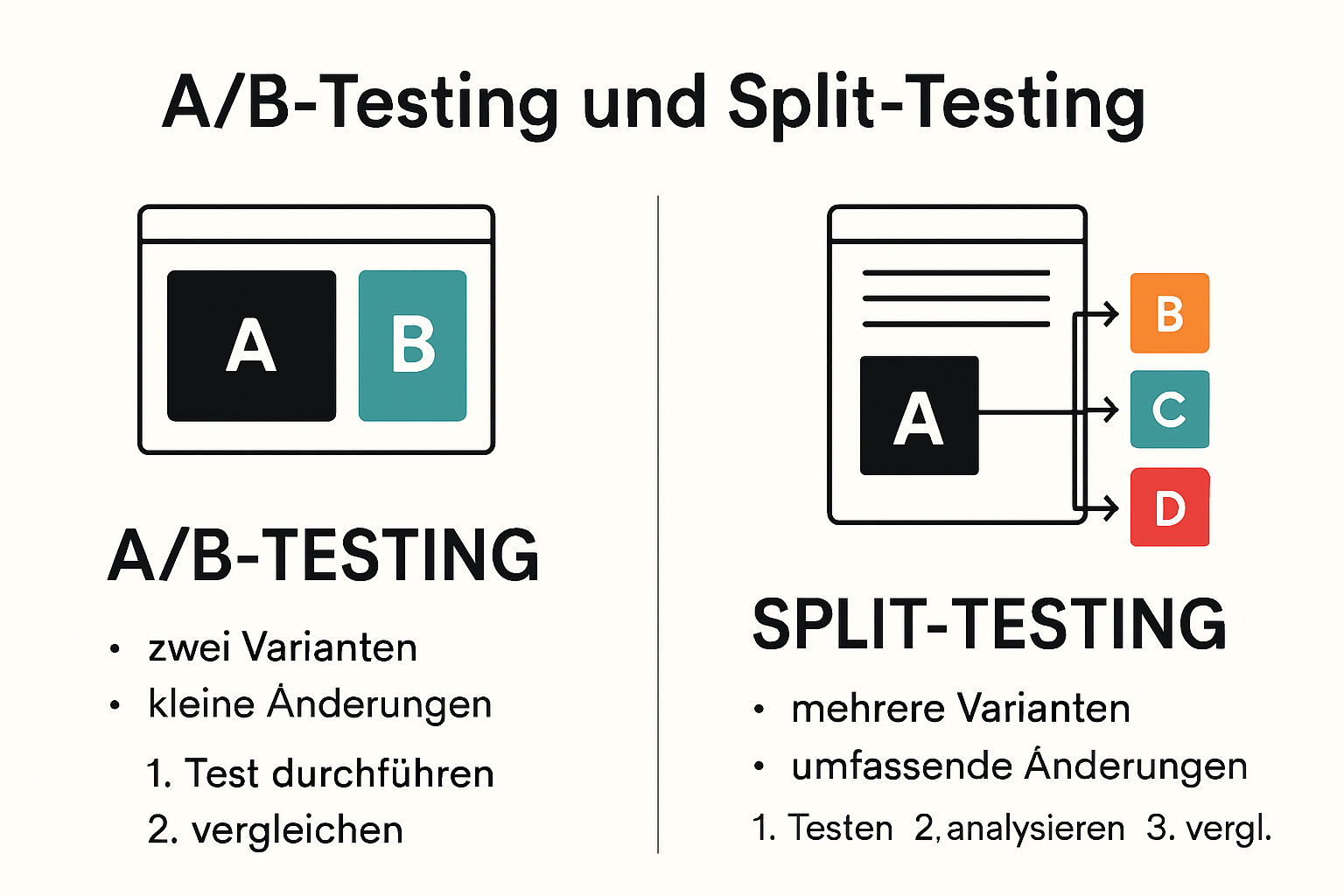

Unternehmen stehen oft vor der Entscheidung, wie sie ihre Webseiten am effektivsten optimieren können. Split Testing klingt nach einer Lösung für Komplexes und A/B Testing verspricht schnelle Ergebnisse. Doch kaum jemand weiß, dass A/B Testing besonders für kleine Anpassungen geeignet ist, während Split Testing bei großen Änderungen sogar mehrere Varianten gleichzeitig prüfen kann. Der Bezug dieser Methoden zu den eigentlichen Marketingzielen überrascht viele, denn die richtige Wahl kann messbar mehr Conversions und größere Lernerfolge bringen.

Inhaltsverzeichnis

- Grundlagen: Was ist Split Testing, was ist A/B Testing?

- Hauptunterschiede: Methoden, Ziele und Anwendungsfälle

- Wann solltest du Split Testing oder A/B Testing nutzen?

- Best Practices für erfolgreiche CRO-Experimente

Kurze Zusammenfassung

| Takeaway | Erklärung |

|---|---|

| A/B Testing für präzise Anpassungen nutzen | Diese Methode eignet sich hervorragend für kleine und gezielte Änderungen, um spezifische Optimierungen schnell umzusetzen. |

| Split Testing für umfassende Vergleiche verwenden | Ideal, um mehrere Versionen gleichzeitig zu testen und weitreichende Erkenntnisse über komplexe Varianten zu gewinnen. |

| Testergebnisse datenbasiert analysieren | Eine systematische Herangehensweise zur Analyse der Ergebnisse ist entscheidend, um fundierte Entscheidungen zu treffen. |

| Zielgerichtete Testmethoden wählen | Die Wahl zwischen A/B Testing und Split Testing sollte strategisch basierend auf spezifischen Marketingzielen getroffen werden. |

| Kontinuierliche Verbesserung etablieren | Ethik und Transparenz sind für CRO-Experimente wichtig, um eine Kultur der ständigen Optimierung zu fördern und zu gewährleisten. |

Grundlagen: Was ist Split Testing, was ist A/B Testing?

Die Welt der digitalen Optimierung hat zwei entscheidende Methoden hervorgebracht, die Unternehmen helfen, ihre Online-Performance zu verbessern: Split Testing und A/B Testing. Beide Ansätze zielen darauf ab, datengesteuerte Entscheidungen zu treffen und Conversion-Raten zu maximieren.

Split Testing im Überblick

Split Testing ist eine experimentelle Methode, bei der verschiedene Versionen einer Webseite, Landingpage oder eines digitalen Elements gleichzeitig getestet werden. Laut Wikipedia ermöglicht diese Technik Unternehmen, mehrere Varianten zu vergleichen und die effektivste zu identifizieren. Im Gegensatz zum klassischen A/B Test können beim Split Testing mehr als zwei Varianten parallel getestet werden.

Beispielsweise könnte ein Unternehmen drei unterschiedliche Designversionen seiner Startseite gleichzeitig testen, um herauszufinden, welche Variante die höchste Conversion-Rate generiert. Jede Version wird einer zufälligen Gruppe von Besuchern präsentiert, wodurch statistische Signifikanz gewährleistet wird.

A/B Testing: Eine präzise Vergleichsmethode

A/B Testing, auch als Split-Test bekannt, ist eine spezifische Form des Split Testings, bei der genau zwei Versionen miteinander verglichen werden. Gemäß wissenschaftlichen Quellen konzentriert sich diese Methode darauf, eine Originalversion (Variante A) mit einer leicht modifizierten Version (Variante B) zu vergleichen.

Unternehmen nutzen A/B Testing häufig für gezielte Optimierungen wie Änderungen von Überschriften, Farbschemen, Call-to-Action-Buttons oder Seitenlayouts. Der Prozess ermöglicht es, sehr präzise Einblicke in Nutzerverhalten und Präferenzen zu gewinnen.

Praktische Bedeutung für Marketer

Bei beiden Methoden geht es darum, fundierte Entscheidungen auf Basis von Daten zu treffen. Mehr über moderne Split-Testing-Strategien erfahren Sie in unserem Leitfaden. Ob Split Testing oder A/B Testing - die zentrale Frage bleibt immer: Welche Version erzeugt bessere Ergebnisse?

Die Wahl zwischen Split Testing und A/B Testing hängt von Ihren spezifischen Optimierungszielen ab. Während A/B Testing ideal für kleine, gezielte Änderungen ist, eignet sich Split Testing besser für umfassendere Vergleiche mit mehreren Varianten. Der Schlüssel liegt darin, die richtige Methode für Ihre individuellen Marketingziele zu wählen."

To clearly illustrate the main differences between A/B Testing and Split Testing, the following table compares their methods, ideal use cases, scope, and typical applications. This will help you quickly determine which approach fits your optimization goals best.

| Aspect | A/B Testing | Split Testing |

|---|---|---|

| Number of Variants | 2 (A vs. B) | 3 or more |

| Complexity | Simple, focused on a single element | Complex, covers entire page/system |

| Typical Use | Small changes (buttons, headlines, colors) | Large changes (layouts, navigation, user journeys) |

| Speed & Resources Needed | Fast, low resource | Slower, more resource-intensive |

| Suitability | Incremetal improvements | Fundamental redesigns, multiple concepts |

| Statistical Design | Binary comparison | Multi-variant comparison |

Hauptunterschiede: Methoden, Ziele und Anwendungsfälle

Während Split Testing und A/B Testing oft synonym verwendet werden, existieren bedeutende Unterschiede in ihren Methoden, Zielen und Anwendungskontexten. Diese Nuancen können den Erfolg Ihrer Optimierungsstrategie entscheidend beeinflussen.

Methodische Unterscheidungen in der Testdurchführung

Der zentrale methodische Unterschied liegt in der Anzahl der gleichzeitig getesteten Varianten. Laut wissenschaftlicher Analyse konzentriert sich A/B Testing auf einen präzisen Vergleich zwischen zwei Varianten, während Split Testing mehrere Versionen parallel testen kann.

A/B Tests sind typischerweise binär strukturiert: Eine Originalversion (Variante A) wird direkt mit einer modifizierten Version (Variante B) verglichen. Split Tests erlauben hingegen komplexere Versuchsanordnungen mit drei oder mehr Varianten. Diese Flexibilität ermöglicht es Marketern, nuanciertere Unterschiede zu identifizieren und umfassendere Erkenntnisse zu gewinnen.

Zielorientierte Differenzierung

Die Ziele beider Testmethoden unterscheiden sich subtil, aber signifikant. Gemäß Forschungsergebnissen verfolgen A/B Tests meist sehr spezifische, eng definierte Optimierungsziele wie Konversionsverbesserung eines einzelnen Elements. Split Tests eignen sich dagegen für ganzheitlichere Evaluationen komplexerer Systemveränderungen.

Während ein A/B Test beispielsweise die Wirkung einer Buttonfarbe untersuchen kann, ermöglicht ein Split Test die Analyse unterschiedlicher Seitendesigns, Navigationselemente oder umfassender Nutzererfahrungen. Erfahren Sie mehr über datengetriebene Entscheidungsstrategien.

Praktische Anwendungsfälle und Strategische Implikationen

Die Wahl zwischen Split Testing und A/B Testing hängt von spezifischen Marketingzielen und Untersuchungsumfang ab. A/B Tests eignen sich hervorragend für inkrementelle Optimierungen mit geringem Ressourcenaufwand. Sie sind präzise und schnell implementierbar, ideal für kurzfristige Verbesserungen.

Split Tests bieten dagegen einen umfassenderen Ansatz. Sie ermöglichen komplexere Experimente und sind besonders wertvoll bei grundlegenden Redesigns, Neuausrichtungen von Marketingstrategien oder der Evaluation mehrerer konkurrierender Konzepte.

Entscheidend ist die strategische Anpassung der Testmethode an die spezifischen Unternehmensziele. Kleine Änderungen erfordern präzise A/B Tests, während weitreichende Transformationen von Split Tests profitieren. Die Kunst liegt darin, die richtige Methode zum richtigen Zeitpunkt einzusetzen und die gewonnenen Erkenntnisse systematisch in Optimierungsstrategien zu überführen.

Wann solltest du Split Testing oder A/B Testing nutzen?

Die Entscheidung zwischen Split Testing und A/B Testing ist entscheidend für eine effektive digitale Optimierungsstrategie. Jede Methode bietet einzigartige Vorteile, die je nach Marketingziel und Untersuchungskontext optimal eingesetzt werden können.

Situationen für A/B Testing

Gemäß Forschungserkenntnissen eignet sich A/B Testing hervorragend für sehr spezifische, eng begrenzte Optimierungen. Wenn Sie kleine, gezielte Änderungen testen möchten, ist A/B Testing die präziseste Methode. Typische Anwendungsfälle umfassen:

- Änderungen von Buttonfarben oder Textformulierungen

- Kleine Designmodifikationen einzelner Elemente

- Kurze Überschriften oder Call-to-Action-Variationen

- Mikrooptimierungen von Nutzeroberflächenelementen

A/B Tests ermöglichen es, sehr präzise Aussagen über die Wirkung minimaler Veränderungen zu treffen. Sie sind schnell durchführbar und liefern schnelle Erkenntnisse mit geringem Ressourcenaufwand.

Ideale Einsatzszenarien für Split Testing

Laut wissenschaftlicher Analyse eignet sich Split Testing für umfassendere und komplexere Optimierungsvorhaben. Nutzen Sie Split Testing in folgenden Situationen:

- Testen komplett unterschiedlicher Seitendesigns

- Evaluierung grundlegender Navigationsstrukturen

- Vergleich verschiedener Kundenjourney-Konzepte

- Analyse umfassender Layoutveränderungen

Split Tests bieten einen ganzheitlicheren Ansatz und erlauben es, mehrere Varianten parallel zu testen. Erfahren Sie mehr über erfolgreiche Optimierungsstrategien.

Strategische Entscheidungskriterien

Die Wahl zwischen Split Testing und A/B Testing hängt von mehreren Faktoren ab:

Below is a summary of typical situations that indicate when to use A/B Testing versus Split Testing. Use this as a quick reference for selecting the appropriate approach for your next CRO experiment.

| Scenario/Goal | A/B Testing | Split Testing |

|---|---|---|

| Test button color or текст change | ✔ | |

| Assess minor layout modifications | ✔ | |

| Evaluate two versions of a call-to-action | ✔ | |

| Compare multiple page layouts | ✔ | |

| Redesign navigation structure | ✔ | |

| Test different customer journey concepts | ✔ | |

| Analyze broad, system-level changes | ✔ |

- Untersuchungsumfang: Kleine Änderungen erfordern A/B Tests, große Transformationen Split Tests.

- Ressourcen: A/B Tests sind schneller und kostengünstiger, Split Tests aufwendiger aber umfassender.

- Marketingziel: Inkrementelle Verbesserungen durch A/B Tests, strategische Neuausrichtungen durch Split Tests.

Entscheidend ist die klare Zielsetzung. A/B Tests optimieren Details, Split Tests revolutionieren Gesamtkonzepte. Die richtige Methode zu wählen bedeutet, Ihre spezifischen Marketingziele präzise zu verstehen und die passende Testmethode strategisch einzusetzen.

Unabhängig von der Methode bleibt das Ziel gleich: kontinuierliche Verbesserung und datenbasierte Entscheidungsfindung, die Ihre Conversion-Raten und Nutzererfahrung nachhaltig steigert.

Best Practices für erfolgreiche CRO-Experimente

Conversion Rate Optimization (CRO) erfordert eine systematische und datengesteuerte Herangehensweise. Die Durchführung erfolgreicher Experimente basiert auf klaren Strategien und methodischen Ansätzen, die sowohl Split Testing als auch A/B Testing optimieren.

Fundamentale Planungsstrategien

Gemäß wissenschaftlicher Forschung beginnt eine erfolgreiche CRO-Strategie mit präziser Vorbereitung. Entscheidende Vorbereitungsschritte umfassen:

- Definieren klarer, messbarer Konversionsziele

- Sammeln ausreichender Hintergrunddaten vor Testbeginn

- Entwickeln einer Hypothese mit spezifischen Erfolgskriterien

- Identifizieren der relevanten Zielgruppe und Verkehrsquellen

Die Hypothesenformulierung ist besonders kritisch. Sie sollte konkret beschreiben, welche Änderung erwartet wird und warum. Beispiel: "Durch Änderung der Buttonfarbe von Blau auf Orange erhöhen wir die Klickrate um mindestens 15 Prozent."

Technische Implementierung und Datenintegrität

Laut Experten für Conversion-Optimierung sind technische Präzision und Datenintegrität entscheidend für zuverlässige Testergebnisse. Wichtige Aspekte umfassen:

- Sicherstellen statistisch signifikanter Stichprobengrößen

- Vermeiden von Interferenzen zwischen parallelen Tests

- Kontrollieren von Variablen und Ausschließen externer Einflüsse

- Implementieren robuster Tracking-Mechanismen

Unser Leitfaden zur Variantenauswahl bietet tiefere Einblicke in effektive Teststrategien. Die Qualität der Datenerhebung bestimmt letztendlich die Validität Ihrer Experimente.

Ethische Dimensionen und Kontinuierliche Optimierung

Erfolgreiche CRO-Experimente erfordern mehr als nur technische Präzision. Sie müssen ethische Aspekte berücksichtigen und eine Kultur kontinuierlicher Verbesserung etablieren:

- Transparenz gegenüber Nutzern über laufende Tests

- Respektieren der Nutzerprivatsphäre

- Regelmäßiges Überprüfen und Validieren von Testergebnissen

- Entwickeln einer Lernkultur basierend auf Experimentdaten

Die größte Herausforderung besteht nicht im Durchführen einzelner Tests, sondern im Aufbau eines systematischen Ansatzes zur kontinuierlichen Optimierung. Jeder Test sollte mehr sein als ein isoliertes Experiment - er ist Teil einer größeren Strategie zur Verbesserung der Nutzererfahrung und Steigerung von Conversions.

Entscheidend ist die Kombination aus technischer Präzision, strategischem Denken und ethischer Reflexion. Nur wenn diese Aspekte zusammenwirken, können CRO-Experimente ihr volles Potenzial entfalten und nachhaltige Verbesserungen generieren.

Häufig gestellte Fragen

Was ist der Hauptunterschied zwischen A/B Testing und Split Testing?

A/B Testing vergleicht zwei Varianten (A vs. B), während Split Testing mehrere Varianten parallel testet. A/B Testing eignet sich für gezielte, kleine Anpassungen, während Split Testing für größere Veränderungen genutzt wird.

Wann sollte ich A/B Testing verwenden?

A/B Testing ist ideal für kleine, präzise Änderungen wie die Anpassung von Buttonfarben, Textformulierungen oder Überschriften. Es ermöglicht schnelle, datengestützte Entscheidungen für konkrete Elemente.

In welchen Fällen eignet sich Split Testing am besten?

Split Testing ist besonders nützlich, wenn Sie komplett unterschiedliche Designs, Navigationsstrukturen oder verschiedene Kundenreisen testen möchten. Es erlaubt umfassendere Vergleiche zwischen mehreren Varianten.

Welche Best Practices sollte ich bei CRO-Experimenten beachten?

Zu den Best Practices gehören klare Zieldefinitionen, ausreichende Daten während der Testphase, die Sicherstellung statistischer Signifikanz und eine ethische Durchführung der Tests. Eine kontinuierliche Überprüfung und Anpassung der Ergebnisse ist ebenfalls wichtig.

Starte jetzt bessere Tests – ohne Kompromisse für Performance

Du möchtest präzise Ergebnisse und echte Conversion-Steigerung erzielen, stehst aber vor der Herausforderung, Split Testing und A/B Testing effizient umzusetzen? Viele Marketer verzetteln sich in komplexen Tools, unübersichtlicher Technik und verlangsamen ihre Webseite. Mit Stellar ist Schluss damit: Unser ultraleichtes Script (nur 5.4KB) sorgt dafür, dass deine Nutzererfahrung unberührt bleibt und alle Tests blitzschnell laufen. Durch den No-Code Editor setzt du Tests direkt um – ohne IT-Support oder lange Lernkurven. Echtzeit-Analytics und dynamische Keywords helfen dir, Split Tests und A/B Tests effektiv auszuwerten und sofort zu reagieren.

Teste noch heute, wie unkompliziert und schnell Conversion-Optimierung sein kann. Sichere dir jetzt die volle Kontrolle über dein Marketing-Experiment – ganz ohne technisches Hindernis. Steige direkt ein auf Stellar und starte mit einem kostenfreien Plan die ersten A/B oder Split Tests – messbare Ergebnisse warten bereits!

Recommended

- Split Testing 2025: Erfolgreiche Optimierung für mehr Conversions

- A/B testen zonder technische kennis: eenvoudig optimaliseren in 2025

- Les avantages de l’a/b testing pour booster vos conversions en 2025

- How to Choose Test Variants: A CRO Marketer’s Guide 2025

- Was ist Split-Testing: Der ultimative Leitfaden für datengestützter Marketing-Erfolg

Published: 8/9/2025