A/B-Testing in 2025: Der große Praxis-Guide für Marketer und Conversion-Optimierer

A/B-Testing wird in der Marketingbranche oft als Allheilmittel gefeiert – schnelle Erfolge, bunte Diagramme, beeindruckende Zahlen. Doch die wahre Stärke liegt im Verständnis der statistischen Signifikanz. Unternehmen, die A/B-Tests gezielt und methodisch auswerten, konnten laut aktuellen Marktstudien ihre Conversion Rates um bis zu 400 Prozent steigern. Das Geheimnis: Nur valide Tests sind echte Gamechanger – alle anderen Zahlen sind Zufallstreffer. Wie Sie echte Durchbrüche von reinen Zufallsschwankungen unterscheiden, erfahren Sie hier.

Inhaltsverzeichnis

- Statistische Signifikanz im A/B-Testing verstehen

- Häufige Stolperfallen & Fehlinterpretationen im A/B-Test

- Wie zuverlässige A/B-Testergebnisse gelingen

- Signifikanz strategisch für Wachstum nutzen

Kompaktübersicht

| Wichtigster Punkt | Erklärung |

|---|---|

| Statistische Signifikanz verstehen | Sie zeigt, ob ein beobachteter Unterschied im A/B-Test wirklich relevant ist oder reiner Zufall – meist bei p < 0,05. |

| Typische Fehler vermeiden | Test nicht zu früh abbrechen, Stichprobengröße beachten, externe Einflüsse erkennen – nur so bleibt Ihr Daten-Fundament stabil. |

| Solides Testdesign | Klare Ziele, eine zu testende Variable, feste Testdauer: Das sind die Grundpfeiler aussagekräftiger Experimente. |

| Modernste Analytics integrieren | Künstliche Intelligenz und fortschrittliche Analyse-Methoden erkennen Muster, beschleunigen Auswertung und ergänzen Ihr Know-how. |

| Business-Relevanz nutzen | Erkenntnisse aus A/B-Tests führen zu messbaren Erfolgen bei Conversion Rate, UX und strategischen Marketingentscheidungen. |

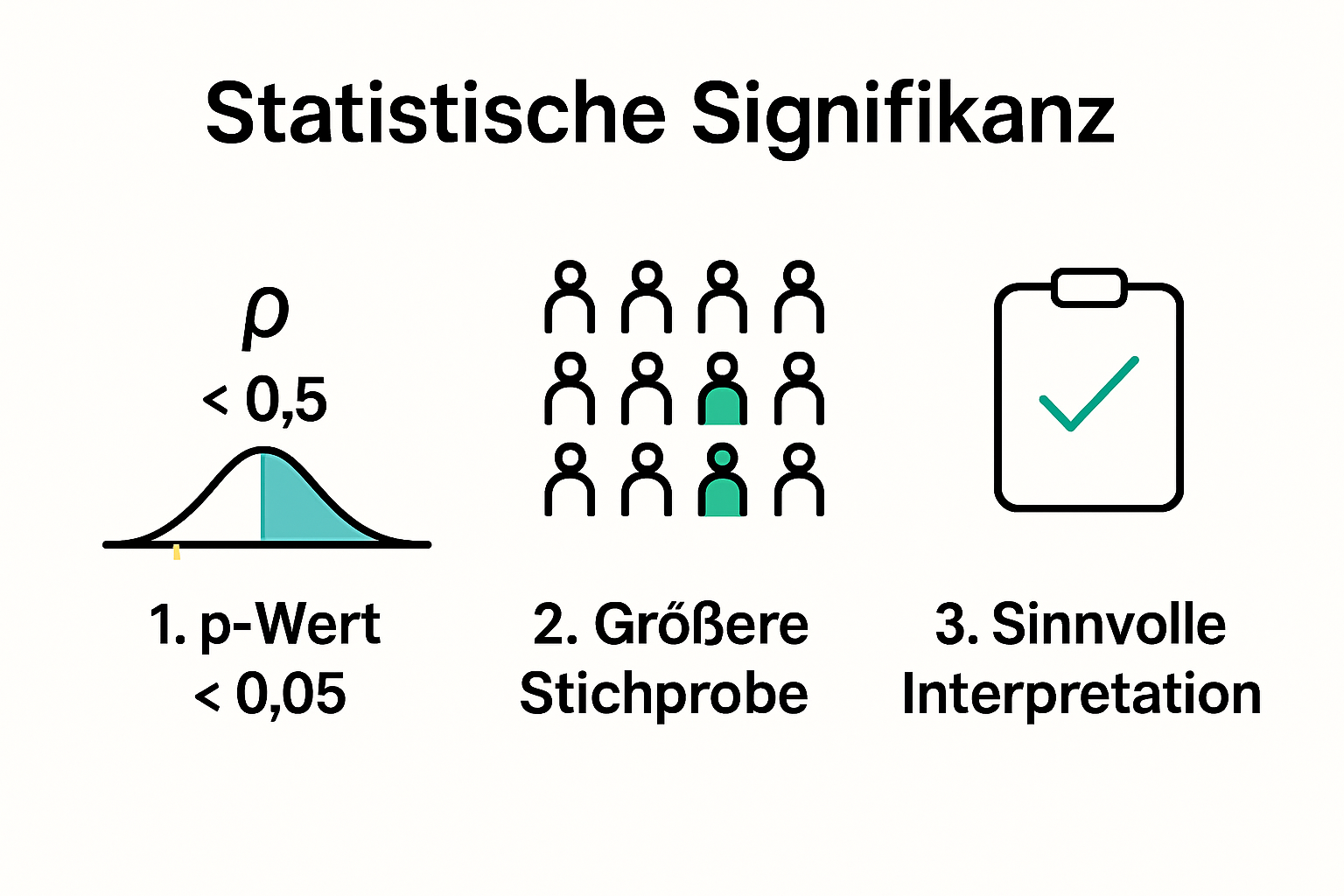

Statistische Signifikanz im A/B-Testing verstehen

Statistische Signifikanz ist die Grundlage, um aus Zahlen echte Erkenntnisse zu gewinnen – und aus A/B-Tests belastbare Maßnahmen für Marketing und CRO abzuleiten. Sie gibt an, ob Unterschiede zwischen Testvarianten wirklich auf Ihrer Optimierung beruhen oder einfach Glück oder Pech sind.

Die mathematische Basis der statistischen Signifikanz

Im Kern beschreibt statistische Signifikanz die Wahrscheinlichkeit, dass ein Testergebnis bloßer Zufall ist. In der Praxis gilt meist: Ist der p-Wert kleiner als 0,05, liegt die Chance für einen Zufall bei unter fünf Prozent – also fast ausgeschlossen. Dieses Vorgehen sorgt für verlässliche Entscheidungen anhand harter Zahlen.

Marketer nutzen diese Methodik, um mit gutem Gewissen datengetriebene Verbesserungen umzusetzen. Systeme wie das Statistik-Framework von Convertize demonstrieren: Ein signifikantes Testergebnis bedeutet, dass eine Maßnahme tatsächlich funktioniert und ein echter Fortschritt erzielt wurde.

Statistische Signifikanz praxisnah interpretieren

Reine Mathematik reicht nicht – es zählt das Verständnis für die Bedeutung hinter dem p-Wert. Ein Praxisbeispiel: Sie testen zwei Landingpages, Variante B erzielt 10 % mehr Conversions als A. Klingt gut, aber: Ohne Signifikanz-Bestätigung riskieren Sie eine Fehlinterpretation. Signifikanz zeigt, ob dieser Anstieg auf Ihre Maßnahmen zurückgeht oder mit Wahrscheinlichkeit auch ohne jedes Zutun entstanden wäre.

Worauf es zu achten gilt:

- Stichprobengröße: Mehr Daten = zuverlässigere Ergebnisse

- Vertrauensniveau: 95 % als Standard im Online-Marketing

- Reproduzierbarkeit: Erfolgreiche Tests sollten stabil wiederholbar sein

Typische Fehler bei der Signifikanzbewertung vermeiden

Klassische Fehler sind u. a.: Tests zu früh stoppen, minimale Stichprobengröße nicht beachten oder externe Faktoren übersehen. Damit wird der Mehrwert des Tests zunichte gemacht. Ein durchdachtes Experimenten-Design und klare Auswertungsregeln sind entscheidend. Wer gezielt vorgeht, verwandelt A/B-Tests vom Zahlenroulette in eine solide Entscheidungsgrundlage.

Häufige Stolperfallen & Fehlinterpretationen im A/B-Test

Selbst das beste Testing bietet keinen Erkenntnisgewinn, wenn typische Fallstricke nicht umgangen werden. Gerade im deutschsprachigen Markt, wo Datenschutz, Saisonalitäten und zielgruppenspezifische Kampagnen eine Rolle spielen, lohnt sich eine strukturierte Testdurchführung.

Voreiliges Testende & Stichprobengröße

Viele Marketer ziehen zu schnell Bilanz – zum Beispiel, wenn die ersten Ergebnisse positiv erscheinen. Ob im E-Commerce, bei DAX-Unternehmen oder Mittelstand: Ein A/B-Test muss bis zum geplanten Endzeitpunkt laufen und die kalkulierte Mindeststichprobe erreichen, sonst sind die Ergebnisse irreführend. Legen Sie deshalb immer vor dem Test Start- und Enddatum sowie die Zielstichprobe fest, wie es z. B. deutsche CRO-Agenturen empfehlen.

Kontextfaktoren & Messverzerrungen

Externe Einflüsse wie saisonale Schwankungen (z. B. Weihnachten oder Schulanfang), parallellaufende Kampagnen oder Produkt-Updates können zu verfälschtem Datenmaterial führen. Deutsche Onlineshops berücksichtigen dabei etwa Ferienzeiten oder spezielle regionale Aktionen. Kontrollieren Sie, dass Ihre Testvarianten in Bezug auf solche Faktoren vergleichbar sind.

Zu enge Metrik-Fokussierung & unerwünschte Nebenwirkungen

Wer sich allein auf Conversion Rate fokussiert, übersieht mögliche Nebenwirkungen auf Nutzererlebnis, Retourenquote oder Kundenbindung. Nur mit einem breiten KPI-Set (auch Absprungrate, Verweildauer, Customer-Lifetime-Value) entsteht ein ganzheitliches Bild – das bestätigen führende deutsche Digitalagenturen regelmäßig.

Wie zuverlässige A/B-Test-Ergebnisse gelingen

Erfolgreiches A/B-Testing benötigt mehr als ein simples Tool. Es braucht ein methodisches Vorgehen und die passende Technologie.

Solides Versuchsdesign etablieren

Ein klar formulierter Testaufbau ist die Basis. Definieren Sie konkrete Ziele, testen Sie pro Experiment exakt eine Variable, und trennen Sie sauber in Test- und Kontrollgruppe. Tests sollten mindestens zwei bis drei Wochen laufen – je nach Traffic und Branche. Gerade im deutschen Onlinehandel, wo Nutzerverhalten je nach Woche oder Feiertag schwanken kann, ist Geduld gefragt.

Die richtige Statistik-Methode wählen

Je nach Fragestellung und verfügbarem Datenvolumen kann ein frequentistischer Ansatz (wie in klassischen deutschen Online-Shops) oder ein Bayes-Ansatz (etwa bei Start-ups mit dynamischer Datenlage) sinnvoll sein. Prüfen Sie, welches Modell Ihre Fragestellung am besten abbildet – viele deutsche Marketing-Tools bieten beide Optionen.

Technologien & qualitative Analyse kombinieren

Künstliche Intelligenz und fortschrittliche Analytics helfen, Datenmuster schneller aufzudecken und auch schwache Effekte sichtbar zu machen. Aber: Am Ende gewinnen Marketer, die Zahlen mit Kunden-Feedback und Branchenwissen verknüpfen – der Mix aus High-Tech und klassischer Marktkenntnis liefert die besten Ergebnisse.

Signifikanz strategisch für Wachstum nutzen

Wer statistische Testergebnisse richtig liest, gewinnt nicht nur Zahlen, sondern einen echten Wettbewerbsvorteil. Zahlen belegen: Unternehmen konnten durch strukturierte A/B-Tests im D-A-CH-Raum ihre Conversion Rate im Durchschnitt um 20–30 % steigern. Etablierte deutsche Unternehmen wie Otto, Zalando oder Check24 setzen seit Jahren auf den datengetriebenen Test- und Optimierungs-Ansatz.

Business-Impact durch Tests quantifizieren

Nutzen Sie Tests nicht als Selbstzweck, sondern beziehen Sie alle Wachstumsbereiche ein: von Conversion-Optimierung über User Experience bis Produktentwicklung. Messen Sie Erfolg wie deutsche Marktführer – etwa entlang von Umsatz pro Nutzer, Retention Rate oder Net Promoter Score.

Expertenwissen sinnvoll umsetzen

Statistische Zahlen machen sich erst dann bezahlt, wenn sie ins Tagesgeschäft einfließen. Bilden Sie interdisziplinäre (Marketing, IT, Vertrieb) Teams, die Test-Insights in konkrete Maßnahmen übertragen. Schaffen Sie eine Unternehmenskultur, in der datenbasierte Entscheidungen zum Standard werden.

Analytics & Experimentierstrukturen effektiv verbinden

Setzen Sie auf moderne Datenanalyse und aussagekräftige Dashboards, um Ergebnisse nicht nur zu messen, sondern auch kontinuierlich zu lernen. Deutsche Digitalunternehmen kombinieren dabei Tests, Customer-Journey-Analysen und Segmentierung, um nicht nur kurzfristige Erfolge, sondern nachhaltige Optimierung zu erzielen.

Häufige Fragen und Antworten

Was bedeutet statistische Signifikanz im A/B-Testing?

Statistische Signifikanz zeigt, ob ein Unterschied im A/B-Test wirklich auf Ihre Maßnahmen zurückgeht, oder reiner Zufall ist. Ein p-Wert kleiner als 0,05 ist dabei der Standard für Signifikanz.

Wie vermeide ich klassische Fehler im A/B-Testing?

Legen Sie immer vorab klare Ziele, Stichprobengröße und Testdauer fest. Lassen Sie Tests nie zu früh enden und berücksichtigen Sie externe Einflussfaktoren.

Was sind Grundprinzipien für zuverlässige A/B-Tests?

Klare Zielsetzung, Fokussierung auf eine Variable, passende Statistikmethoden wählen und immer quantitatives mit qualitativem Feedback kombinieren.

Wie kann A/B-Testing mein Geschäft wirklich wachsen lassen?

Durch Erkenntnisse aus A/B-Tests steigern Sie Conversion Rates, verbessern die Nutzererfahrung, optimieren Ihre Kommunikation und treffen datenbasierte Business-Entscheidungen.

Schluss mit Rätselraten – entdecken Sie die Kraft von validem A/B-Testing

Sie haben gesehen: Nur ein methodisch korrekt durchgeführter und ausgewerteter A/B-Test liefert echte Erkenntnisse für Ihr Online-Business. Unsichere Ergebnisse, frustrierende Datenauswertungen oder zu frühes Testende müssen nicht sein – setzen Sie jetzt auf solide Methodik und spürbaren Mehrwert.

Stellar bietet ambitionierten Marketern und Wachstums-Teams ein leichtgewichtiges A/B-Testing-Tool, das Ergebnisse liefert, statt nur hübsche Statistiken zu produzieren. Mit einem schnellen, datensparenden Code, intuitivem Editor und Echtzeit-Statistik können Sie Tests unkompliziert und konversionsstark umsetzen – ohne Ihre Ladezeiten zu belasten. Testen Sie Stellar noch heute kostenlos und erleben Sie, wie effizientes Testing im deutschen Markt funktioniert. Sorgen Sie dafür, dass Sie valide Insights bekommen – und nicht dem Zufall die Kontrolle überlassen.

Empfehlenswerte Artikel

- A/B-Testing: Sinn, Nutzen & datenbasierte Verbesserungen

- A/B-Testing im Digital-Marketing: Beste Strategien 2025

- Split-Testing für Conversion-Optimierer im Jahr 2025

- A/B-Testing im Digital-Marketing: Definition & Praxisleitfaden

- CRO-Strategien 2025: Mit Testing zu mehr Conversion

- Conversion Rate Optimierung: Top-Strategien 2025

Published: 6/28/2025